사용자 행동을 추적하고 분석하는 건, 사실 모든 디지털 서비스에서 빠질 수 없는 부분이죠. 참여자 행동 데이터를 제대로 로그화하고 시각화할 수 있는 백엔드 시스템을 만들면 사용자 경험이 정말 달라집니다.

이 글에서는 데이터 수집부터 마지막 시각화 단계까지, 백엔드 전체 흐름을 한번 같이 살펴보려 해요. 아키텍처 설계 방법이랑 데이터 처리 기술도 단계별로 풀어볼게요.

제가 직접 구현하면서 느꼈던 효율적인 로그 관리 팁이나 시각화 도구 활용법도 곁들여서 공유해볼 생각입니다. 이런 흐름을 참고하면 여러분도 꽤 강력한 데이터 분석 시스템을 만들 수 있을 거예요.

참여자 행동 데이터 로그화의 개념과 중요성

참여자 행동 로그란, 말 그대로 사용자 활동을 체계적으로 기록해두는 데이터라고 보면 됩니다. 이게 생각보다 비즈니스 성장이나 연구 쪽에서 꽤 큰 힘을 발휘하거든요.

행동 데이터 로그의 정의

행동 데이터 로그는 참여자가 시스템에서 뭘 했는지, 그걸 시간순으로 쭉쭉 남겨놓은 데이터에요.

여기에는 클릭, 스크롤, 페이지 이동, 검색, 구매 등등, 거의 모든 행동이 들어갈 수 있죠. 각 로그엔 타임스탬프, 사용자 ID, 행동 유형, 위치 정보 이런 게 담깁니다.

로그 데이터는 주로 JSON이나 CSV 같은 구조로 저장되고, 실시간으로 모아서 데이터베이스에 넣는 경우가 많아요.

| 데이터 유형 | 포함 정보 | 예시 |

|---|---|---|

| 클릭 이벤트 | 버튼 ID, 위치 | 로그인 버튼 클릭 |

| 페이지뷰 | URL, 체류시간 | 상품 페이지 30초 체류 |

| 검색 이벤트 | 검색어, 결과 수 | “노트북” 검색 |

로그화의 비즈니스 및 연구적 가치

로그 데이터가 있으면 사용자 경험 개선이나 비즈니스 의사결정에 진짜 도움이 됩니다.

제품 개발팀은 이 데이터를 보고 사용자 여정이 어떻게 흘러가는지, 어디서 자주 이탈하는지 이런 걸 파악하죠.

마케팅팀은 캠페인 효과도 측정하고, 타겟 고객을 더 세분화할 수 있어요. 연구자들은 사용자 행동 패턴을 파고들어서 새로운 인사이트도 찾고요.

매출 올리려고 A/B 테스트도 자주 하는데, 이런 것도 결국 로그 데이터가 있어야 제대로 할 수 있습니다. 실제 데이터만큼 믿을 만한 게 또 없으니까요.

주요 활용 사례

이커머스 플랫폼에서는 구매 전환율 높이려고 로그 데이터 엄청 씁니다.

장바구니 이탈 지점 찾아서 결제 과정을 개선한다든가, 상품 추천도 과거 구매 이력이나 탐색 패턴을 바탕으로 돌아가죠.

교육 플랫폼은 학습자 진도, 이해도 같은 걸 파악해요. 어려운 구간에서 반복 학습 패턴이 보이면 그에 맞춰 콘텐츠를 손보기도 하고요.

게임 회사는 플레이어 행동을 쭉 추적합니다. 레벨별 이탈률, 아이템 사용, 플레이 시간 이런 걸 실시간으로 모니터링해서 게임 밸런스도 계속 조정하고요.

금융 서비스 쪽은 이상 거래 탐지나 고객 세분화에 로그 데이터를 많이 씁니다.

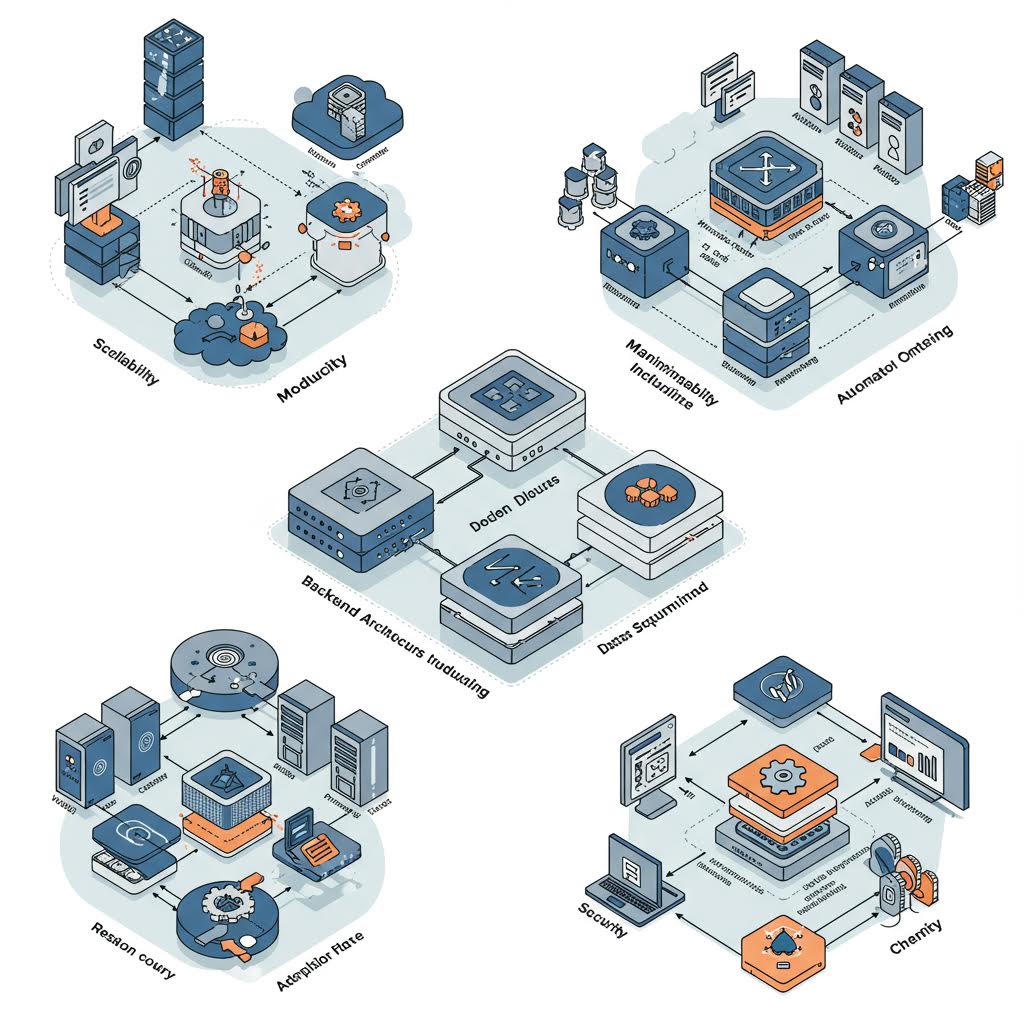

백엔드 아키텍처 설계 원칙

효과적인 데이터 파이프라인을 만들려면, 실시간 수집과 처리를 위한 구조가 명확해야겠죠. 그리고 대용량 행동 데이터를 안정적으로 다루려면 스키마 설계랑 저장 전략도 꽤 신경 써야 해요.

데이터 수집 파이프라인 설계

실시간 데이터 수집에는 Apache Kafka를 메시지 큐로 자주 씁니다. 클라이언트에서 발생하는 모든 사용자 행동을 JSON으로 받아오고요.

파이프라인은 대략 이렇게 세 단계로 나눌 수 있습니다:

- 수집: REST API 엔드포인트로 이벤트 데이터 받기

- 변환: 원시 데이터를 표준 포맷으로 가공

- 저장: 처리된 데이터를 DB에 저장

Spring Boot 애플리케이션에서는 @EventListener 어노테이션으로 비동기 처리를 구현할 수 있어요. 이게 생각보다 처리량을 높이는데 꽤 유용합니다.

데이터 손실 방지하려고 Redis를 임시 버퍼로 쓰기도 해요. DB 장애가 나도 일단 데이터는 안전하게 보관할 수 있거든요.

데이터 스키마 및 저장 전략

시계열 데이터 특성 때문에 InfluxDB를 주 저장소로 선택하는 경우 많아요. 타임스탬프 기반 인덱싱 덕분에 조회 속도가 빠르죠.

기본 스키마는 이런 식이에요:

| 필드명 | 타입 | 설명 |

|---|---|---|

| timestamp | datetime | 이벤트 발생 시각 |

| user_id | string | 사용자 식별자 |

| event_type | string | 행동 유형 |

| properties | json | 추가 속성 데이터 |

PostgreSQL도 메타데이터 저장용으로 병행해서 씁니다. 사용자 정보나 세션 데이터는 관계형 구조가 더 편하니까요.

그리고 데이터 보관 정책을 따로 둬서 30일 지난 데이터는 압축해서 저장합니다. 저장 비용도 아끼고, 장기 분석할 때도 문제없어요.

행동 로그 데이터 처리 및 관리

사용자 행동 데이터를 제대로 수집·처리하려면 실시간 수집 시스템이랑 믿을 만한 저장소가 꼭 필요합니다. 대용량 데이터라면 분산 처리 방식도 무시 못 하고요.

실시간 데이터 수집 방식

웹소켓을 써서 사용자의 클릭, 스크롤, 페이지 이동 같은 걸 실시간으로 받아옵니다. 클라이언트에서 이벤트가 터지면 바로 서버로 보내는 구조죠.

Apache Kafka로 대량 이벤트 데이터를 안정적으로 처리하고, 각 이벤트는 JSON에 타임스탬프랑 사용자 ID를 꼭 담아요.

{

"userId": "user123",

"eventType": "click",

"timestamp": "2025-07-28T10:30:00Z",

"elementId": "submit-button"

}

Redis로 임시 캐싱하면서 중복 이벤트도 필터링합니다. 네트워크 지연이나 연결 불안정 때문에 데이터가 날아가는 걸 막는 거죠.

이벤트 트래킹 구현 기술

프론트엔드에서는 JavaScript SDK를 직접 만들어서 자동으로 사용자 행동을 추적하게 합니다. DOM 이벤트 리스너를 등록하고, 특정 액션이 발생할 때마다 데이터 수집하는 식이죠.

서버 사이드에선 Express.js랑 Socket.io로 실시간 데이터 수신 엔드포인트를 만듭니다. 이벤트를 검증하고, DB 스키마에 맞게 변환해서 저장하고요.

주요 트래킹 이벤트:

- 페이지 뷰

- 버튼 클릭

- 폼 제출

- 스크롤 깊이

- 마우스 움직임

MongoDB도 많이 씁니다. 비정형 이벤트 데이터를 유연하게 저장할 수 있고, 인덱싱으로 사용자별·시간별 쿼리도 빠르게 할 수 있어요.

분산 처리 및 데이터 적재

Apache Spark로 대용량 로그 데이터를 병렬 처리합니다. 배치 처리로 일정 시간마다 누적된 데이터를 분석하기 쉬운 형태로 바꿔주고요.

데이터 웨어하우스는 Amazon Redshift를 써서 장기 데이터를 저장하고 분석합니다. ETL 파이프라인을 돌려서 원시 데이터를 정제하고 집계 테이블도 만들어줘요.

처리 단계:

- 원시 데이터 수집

- 데이터 검증 및 정제

- 집계 테이블 생성

- 분석용 데이터 마트 구축

Docker랑 Kubernetes로 처리 인스턴스를 자동 확장합니다. 트래픽이 갑자기 늘어나면 컨테이너를 더 만들어서 처리량을 맞추는 식이죠.

시각화용 데이터 가공 및 분석

원시 로그 데이터는 그냥 바로 시각화할 순 없고, 중간에 꼭 가공 과정을 거쳐야 해요. 데이터 정제, 패턴 분석, 집계 변환 이런 걸 통해서 진짜 쓸 만한 인사이트가 나옵니다.

ETL 과 데이터 프리프로세싱

추출(Extract) 단계에선 여러 소스에서 참여자 행동 로그를 긁어모으는 작업이 먼저예요. 웹 서버 로그, DB 테이블, 그리고 API 응답 데이터까지, 종류도 다양해서 한데 모으는 게 생각보다 귀찮을 때도 있죠.

변환(Transform) 과정에서는 데이터 형식을 맞춰줘야 합니다. 예를 들어, 타임스탬프는 전부 UTC로 바꿔두고, 사용자 ID는 익명 처리하는 게 기본이죠. 이게 은근히 번거로운데, 안 해두면 나중에 분석할 때 골치 아파집니다.

중복 로그는 꼭 지워야 하고, 누락된 필드도 그냥 두면 안 돼요. 데이터 타입이 이상하거나, 범위를 벗어난 값들은 걸러내야 나중에 덜 고생합니다. 이런 거 하나하나 신경 안 쓰면, 결과가 엉뚱하게 나오는 경우가 많더라구요.

적재(Load) 단계에선 이제 정제된 데이터를 분석용 DB나 데이터 웨어하우스에 집어넣습니다. 인덱스도 걸어두면 조회 속도 훨씬 빨라져서, 이 부분은 꼭 챙기는 게 좋더라고요.

행동 패턴 분석 기법

세션 분석을 하면 사용자의 방문 패턴이 좀 더 명확하게 보입니다. 세션 시작/종료 시점 잡는 것도 중요하고, 평균 체류 시간 계산해보면 의외로 재미있는 인사이트가 나올 때가 있어요.

페이지 플로우 분석은 진짜 유용한데, 사용자가 어디서 어떻게 이동하는지 흐름이 한눈에 들어옵니다. 자주 쓰는 경로나, 이탈 지점 같은 것도 잡아낼 수 있고요.

코호트 분석은 말 그대로 특정 시점에 가입한 유저들만 따로 떼서 행동 변화를 보는 건데요, 시간 지나면서 참여도가 어떻게 달라지는지 확인할 수 있어서 꽤 쓸만합니다.

이벤트 퍼널 분석은 사용자가 목표까지 가는 과정을 단계별로 쪼개서 보는 겁니다. 각 단계에서 얼마나 빠지는지(드롭오프), 또 전환율은 어떤지 이런 거 체크할 수 있죠.

인사이트 도출을 위한 집계 및 변환

시간별 집계는 뭐랄까, 기본 중의 기본이죠. 시간대, 요일, 월별로 사용 패턴을 보면 피크 타임이 언제인지 금방 알 수 있습니다. 콘텐츠별 감정 반응 데이터를 기반으로 자동 분류하는 구조 고찰: 머신러닝 기반 분류 시스템의 설계와 성능 분석 의외로 새벽에 트래픽이 몰릴 때도 있고요.

사용자 세그먼트별 집계를 하면, 신규 유저랑 기존 유저가 어떻게 다르게 행동하는지 확실히 비교할 수 있어요. 그룹별로 차이가 은근히 큽니다.

데이터를 피벗 테이블로 바꿔서 다차원 분석도 해봅니다. 행, 열에 변수 바꿔가면서 교차로 보면, 그냥 집계만 할 때랑은 또 다른 패턴이 보이거든요.

통계적 지표도 빼놓을 수 없죠. 평균, 중앙값, 표준편차 이런 거 구해서 이상치도 잡아내고, 데이터 전체 분포를 좀 더 감으로 파악할 수 있습니다.

시각화 구현 및 사용자 피드백 반영

시각화 제대로 하려면 도구도 잘 골라야 하고, 사용자 입장에서 설계하는 게 진짜 중요해요. 대시보드 만들 때나 피드백 받을 때, 실제로 쓰는 사람들 얘기 듣는 게 도움이 꽤 됩니다.

시각화 도구 및 인터페이스 설계

시각화는 Chart.js, D3.js 이런 라이브러리들 한 번씩 다 써봤는데요, Chart.js는 가볍고 빠르게 쓸 때 괜찮고, D3.js는 커스텀 복잡한 시각화할 때 강력합니다. 뭐, 상황 따라 다르죠.

인터페이스 디자인할 때는 사용자의 실제 업무 흐름을 생각해야 해요. 자주 쓰는 기능은 메인에 딱 보이게, 세부 분석은 드롭다운이나 탭으로 빼두는 게 편하더라구요.

핵심 설계 원칙:

- 3클릭 이내에 원하는 데이터까지 가기

- 색상으로 구분해서 한눈에 이해할 수 있게

- 반응형으로 모바일 지원도 필수

차트 렌더링은 비동기로 돌려서 로딩 시간 줄이고, 데이터 많을 땐 페이지네이션 써야 성능이 좀 나옵니다. 이거 안 하면, 화면 멈추거나 브라우저가 버벅거릴 때도 있어요.

대시보드와 리포트 개발 전략

대시보드는 크게 실시간 모니터링용이랑 정기 분석용으로 나눠서 만듭니다. 실시간 대시보드는 진짜 핵심 지표만 보여주고, 자세한 분석은 따로 페이지 만들어서 빼두는 게 낫더라구요.

리포트는 사용자 역할마다 다르게 구성해야 해요. 관리자는 전체 통계 위주, 팀 리더는 팀별 성과, 개인은 자기 활동 데이터 중심으로. 이게 생각보다 신경 쓸 게 많아요.

| 대시보드 유형 | 업데이트 주기 | 주요 기능 |

|---|---|---|

| 실시간 모니터링 | 5초 | 현재 접속자, 활동률 |

| 일일 분석 | 1시간 | 트렌드, 비교 분석 |

| 주간 리포트 | 매일 자정 | 종합 통계, 성과 지표 |

자동 리포트 생성 기능도 꼭 있으면 좋습니다. 정기적으로 결과를 이메일로 보내주니까, 굳이 들어와서 확인 안 해도 되고 편해요.

사용자 인터랙션 및 피드백 활용

차트마다 맨 아래에다가 평가 버튼을 달아놨어요. 사실 뭐 거창한 건 아니고, “유용함”, “보통”, “개선 필요”—이렇게 세 가지 중에 하나만 딱 고르면 됩니다. 복잡하게 할 필요 없으니까요.

모인 피드백 데이터는 따로 테이블에 쌓아두고, 일주일에 한 번씩 꺼내서 살펴봅니다. 낮은 점수를 받은 차트부터 손봐야겠죠? 아무래도 그런 게 더 눈에 들어오니까요.

피드백 반영 프로세스:

- 사용자 의견 모으고, 일단 분류부터 합니다.

- 기술적으로 가능한지 검토하고, 뭐부터 할지 우선순위도 정해야죠.

- 개선 방향 잡아서 직접 테스트도 해보고,

- 단계별로 배포하면서 계속 모니터링합니다. 뭔가 또 문제 생기면 바로잡고요.

그리고 사용자 행동 패턴도 같이 분석해요. 잘 안 쓰는 기능은 그냥 과감하게 숨기거나 없애버리기도 하고요. 클릭 히트맵 같은 것도 참고해서, 인터페이스 배치도 조금씩 만져봅니다. 이게 생각보다 꽤 도움이 되더라고요.